728x90

반응형

이전 글 : 2022.08.03 - [데이터/빅데이터분석기사] - [빅데이터 분석기사 필기] 1과목 - 빅데이터 분석 기획 #2

지난 포스트에서는 어떻게 빅데이터 분석에 대한 전체적인 계획을 수립했다. 이번에는 데이터 수집 및 저장 계획을 어떻게 수립해야 하는지 배워보겠다. 이 글은 데이터에듀에서 발행한 '빅데이터 분석기사 필기' 교재의 146~178페이지에 해당하는 내용을 참고하였다.

※ 출처가 있는 이미지를 클릭하면 원 사이트로 접속된다.

Index

2. 데이터 수집 및 저장 계획

1) 데이터 수집 및 전환

(1) 데이터 수집 및 전환

- 빅데이터 수집 기법 : Log Aggregator, 크롤링, 스크래핑 (자동으로 웹 사이트의 특정 정보 추출), Open API, RSS 등

- 정형 데이터 :

- ETL (Extract Transform Load) : 데이터 웨어하우스와 데이터 마트로 데이터를 보내기 위해 활용하는 추출, 변환, 적재 프로세스

- FTP (File Transfer Protocol)

- API (실시간 데이터 수신)

- 반정형

- 로그 수집기 (scribe - 페이스북, Chukwa 등)

- 비정형

- 크롤링, 스크래피 (Python으로 만들어짐), 아파치 카프카 (스트리밍 데이터 처리), RSS, Open API

- 크롤링 = 스파이더링, 가장 흔함. 데이터 위치의 분류 작업이 주목적.

- 스크래피와 아파치 카프카의 활용이 늘어나는 중.

- 정형 데이터 :

- 데이터 소스에 따른 수집 방법 : 내부 데이터 (ETL) ↔ 외부 데이터 (크롤링)

- 빅데이터 수집 시스템의 요건 : 확장성, 안정성, 유연성, 실시간성

- 빅데이터 수집 절차 : 수집 대상 선정 → 수집 계획 수립 ↔ 수집 실행

(2) 데이터 유형 및 속성 파악

- 데이터 유형

- 일반적 데이터 특징 : 정성적 (언어, 외부 시스템) VS 정량적 (숫자, 내부 시스템)

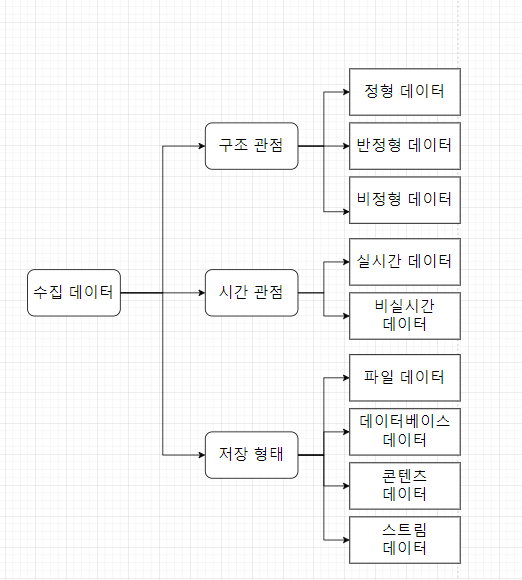

- 구조 관점의 데이터 유형

- 정형 데이터 : 정형화된 스키마, 일관성 O, RDB, 스프레드시트, 통계

- 반정형 데이터 : 정형화된 스키마, 메타 데이터 포함, XML, HTML, JSON

- 비정형 데이터 : 스키마 X, SNS, NoSQL

- 스키마? (출처 : 티스토리 - 코딩팩토리 (이미지 포함))

- 스키마는 데이터베이스의 구조와 제약 조건에 관한 전반적인 명세를 기술한 메타데이터의 집합.

- 스키마는 데이터베이스를 구성하는 데이터 개체(Entity), 속성(Attribute), 관계(Relationship) 및 데이터 조작 시 데이터 값들이 갖는 제약 조건 등에 관해 전반적으로 정의함.

- 스키마는 사용자의 관점에 따라 외부 스키마, 개념 스키마, 내부 스키마로 나뉨.

- 시간 관점의 데이터 유형

- 실시간 데이터 : 센서 데이터, 시스템 로그, 알람 등

- 비실시간 데이터 (배치 데이터) : 통계, 웹 로그, 구매 정보, 헬스케어 정보 등

- 저장 형태 관점의 데이터 : 파일, 데이터베이스, 콘텐츠, 스트림 데이터 (네트워크를 통해 실시간 전송되는 데이터)

(3) 데이터 변환

- 일반적으로 ETL 과정을 의미.

- 컴퓨터가 바로 처리할 수 없는 반정형, 비정형 데이터를 정형 데이터의 구조로 바꾸는 것을 뜻함.

- 레거시 데이터 : 기존에 모아두거나 활용한 데이터

- 데이터 전·후처리

- 전처리 : 수집한 데이터를 저장소에 적재하기 위해 필터링, 타입 변환, 정제 등의 처리를 하는 것.

- 후처리 : 분석에 용이하도록 통합, 축소 등의 처리를 하는 것

- 고려사항

- 전처리 : 실패 이력 저장 및 해당 내용 전달, 결과 데이터 저장 등

- 후처리 : 이상치 변환 및 추천 기능, 데이터 요약 기능 등

- 데이터 변환 기술

- 평활화 (Smoothing) : 노이즈 제거를 위해 추세에서 벗어난 값을 변환. 구간화, 군집화 사용

- 집계

- 일반화 : 특정 구간에 분포하는 값으로 스케일 변화. 범용 데이터에 적합한 모델을 만드는 방법

- 정규화 : 정해진 구간에 포함되도록 함. z-스코어 정규화, 소수 스케일링 등 통계적 기법 활용.

- 속성 생성 : 통합을 위해 새로운 속성 생성

- ETL 프로세스

- 이동 및 변환이 주목적. 통합, 이동, 마스터 데이터 관리 등에도 활용.

- 일괄 ETL (Batch ETL)과 실시간 ETL로 나뉨.

- ETL의 역할 : 소스 레이어 (수집), DW 레이어 (관리), 분석 레이어 (분석)

- 데이터 변환 절차

- 비정형 데이터 → 정형 데이터로 변환 시, 관계형 DBMS 자주 활용.

- 데이터 구조 정의 - 수행 코드 정의 - 프로그램 작성 - DB 저장

(4) 데이터 비식별화

- 20년 8월, 데이터 3법의 시행으로 이목이 쏠리고 있는 분야.

- 데이터 보안 : 사용자 인증, 접근 제어, 암호화, 개인정보 비식별화, 개인정보 암호화 등의 기술 활용.

- 비식별화

- 데이터 자체로 개인을 특정할 수 있는 데이터 대상 (다른 정보와 쉽게 결합해 특정할 수 있는 것도 포함)

- 즉, 식별자(고유식별정보, 생체정보 등)와 준식별자( 개인 특성, 신체 특성 등)를 대상으로 함.

- 비식별화 기술

- 식별 방지 : 가명처리 (암호화 등), 총계처리 (라운딩 등), 데이터 삭제, 데이터 범주화 (랜덤 라운딩 등), 데이터 마스킹 (섭동, 교란 등)

- 추론 방지 : k-익명성, l-다양성 (k-익명성 보완), t-근접성 (l-다양성 보완)

(5) 데이터 품질 검증

- 데이터 품질 : 조직의 목적 달성을 위해 관리되는 데이터가 이용자의 만족을 충족시킬 수 있는 수준을 의미. (한국데이터베이스진흥원)

- 품질 관리의 중요성 : 신뢰성 확보, 일원화된 프로세스 (효율성), 활용도 향상, 양질의 데이터 확보.

- 데이터 품질 기준

- 정형 데이터 : 완전성, 유일성, 유효성, 일관성, 정확성

- 비정형 : 신뢰성, 기능성, 효율성, 사용성, 이식성

- 품질 진단 방법 : 프로파일링 (값 진단, 구조 진단), 체크리스트 (인터뷰), 업무규칙 (BR) 진단, 비정형 실측

2) 데이터 적재 및 저장

(1) 데이터 적재

- 데이터의 신뢰성 확보를 위한 오류 대책 및 검증 방안을 준비해야 함.

- 데이터 마이그레이션 (migration) ETL 설계 : 데이터 변경에 대한 타임스탬프 관리 요구됨.

(2) 데이터 저장

- 빅데이터 저장 기술 : 분산 파일 시스템, NoSQL, 클라우드 등

- 빅데이터 저장 기술은 구글과 애플의 완성도가 높고, 솔루션은 하둡과 아파치 카산드라가 대표적. 한국 개발 솔루션은 GLORY-FS 등이 있음.

- 분산 파일 시스템 : 데이터를 수집, 저장, 분석하기 위해 두 대 이상의 컴퓨터로 작업하고 발생한 문제에 대응하는 방식

- 하둡, HDFS (하둡 분산 파일 시스템, 클라우드용), GFS (구글)

- NoSQL : 비정형 데이터의 저장과 관리를 위해 만들어진 기술 (Cassandra, HBase - 네이버 라인에 적용)

- 빅데이터 저장을 위한 고려사항

- 설치와 유지보수 비용까지 고려한 TCO (Total Cost of Ownership) 실현

- 데이터 관리 기술

- 용량의 확장성

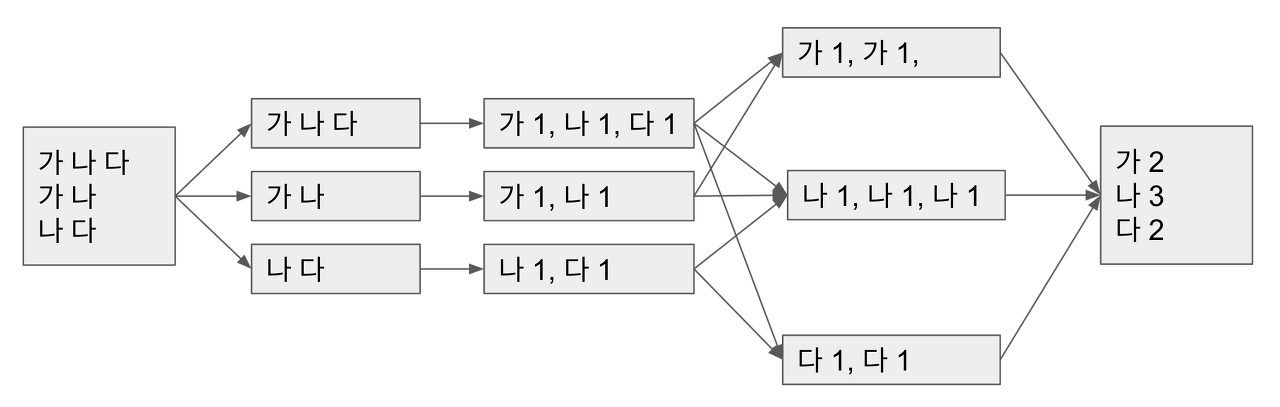

- 맵리듀스 : 간단한 단위를 처리하는 맵 작업과 그 작업물을 집계하는 리듀스 단계로 구성.

- 데이터 웨어하우스

- 데이터를 분석 가능한 형태로 저장한 저장소

- 특징 : 통합성, 주제지향성, 시계열성, 비휘발성

- 데이터 레이크

- 다양한 분야의 Raw Data를 형식을 불문하고 저장하는 시스템으로 저장 및 접근도 쉽게 할 수 있는 저장소 (아파치 하둡, Teradata 등이 플랫폼으로 이루어진 솔루션 서비스)

- 특징 : ETL 필요없음. 유연성 O, 확장성 O, 다양한 데이터를 취급하기 때문에 분석이 어려워 솔루션 필요함.

- 데이터 거버넌스

- 전사 차원의 데이터에 대해 관리체계를 수립하고 운영을 위한 프레임워크 및 저장소를 구축하는 것을 뜻함.

- 중요 대상 : 마스터 데이터, 메타 데이터, 데이터 사전

- 구성 요소 : 원칙, 조직, 프로세스

- 데이터 거버넌스 체계 : 데이터 표준화 ↔ 관리 체계 ↔ 저장소 관리 ↔ 표준화 활동

- 데이터 리터러시 : 데이터를 이해하고 분석하며 활용할 수 있는 능력.

- IT 거버넌스 : IT자원의 효율적 활용을 위한 관리/통제 체계

♧ 예상문제 오답노트

- 로그 수집기 : Flume / Scribe - 페이스북에서 개발한 실시간 스트리밍 로그 데이터 수집 앱 / Chukwa - 야후 채택

- NoSQL은 비정형 데이터

- 저장 형태에 따른 데이터

- 콘텐츠 데이터 : 텍스트, 이미지처럼 개별적으로 데이터 객체로 분류되는 미디어 데이터.

- 파일 데이터 : 시스템 로그, 서비스 로그, 텍스트, 스프레드시트

- 데이터 삭제 예시 : 891111-2122233 > 여자, 80년대생

- 레코드 삭제와 식별자 삭제는 다름.

- 데이터 품질 정의 : 특정 비즈니스 목적으로 특정 사실의 부합 여부를 결정하기 위해 사용되는 주관적 기준 (IBM)

- 품질 진단 방법 - 비정형 실측 : 정보를 사람이 직접 오류 확인

- HDFS는 사용자의 직접 접근 권한을 지원하지 않음.

- HBase : 구글 Bigtable을 샘플로 하여 자바 기반으로 개발된 비관계형 DB (대표적 NoSQL)

- NoSQL은 SQL을 쓰지 않으므로 join도 없다.

- NoSQL : RDBMS의 주요특성인 ACID는 제공하지 않으나 뛰어난 확장성과 성능을 제공하는 저장 시스템

728x90

반응형

'Cerificate > 빅데이터분석기사' 카테고리의 다른 글

| [빅데이터분석기사 필기] 2과목 - 빅데이터 탐색 (3/3) (어려움) (0) | 2022.08.09 |

|---|---|

| [빅데이터분석기사 필기] 2과목 - 빅데이터 탐색 (2/3) (0) | 2022.08.07 |

| [빅데이터 분석기사 필기] 2과목 - 빅데이터 탐색 (1/3) (0) | 2022.08.05 |

| [빅데이터 분석기사 필기] 1과목 - 빅데이터 분석 기획 (2/3) (0) | 2022.08.03 |

| [빅데이터 분석기사 필기] 1과목 - 빅데이터 분석 기획 (1/3) (0) | 2022.08.01 |